Onderzoekers van de Aarhus Universiteit in Denemarken, waaronder psycholoog Søren Ostergaard, hebben onderzoek gedaan naar de impact van AI-chatbots op het onderscheiden van waarheid en leugen. Ze benadrukken dat AI-chatbots vaak positieve, maar overwegend niet-realistische antwoorden geven op de vragen van gebruikers, wat de problemen van mensen met mentale instabiliteit verergert. Een team van Stanford University heeft ook de beperkingen en risico’s van AI-chatbots bestudeerd. Hun bevindingen tonen aan dat deze chatbots in sommige gevallen verkeerde opvattingen en steun bieden die verband houden met mentale aandoeningen, wat de toestand van patiënten verder kan verergeren.

Hoe verhogen AI Chatbots de risico’s?

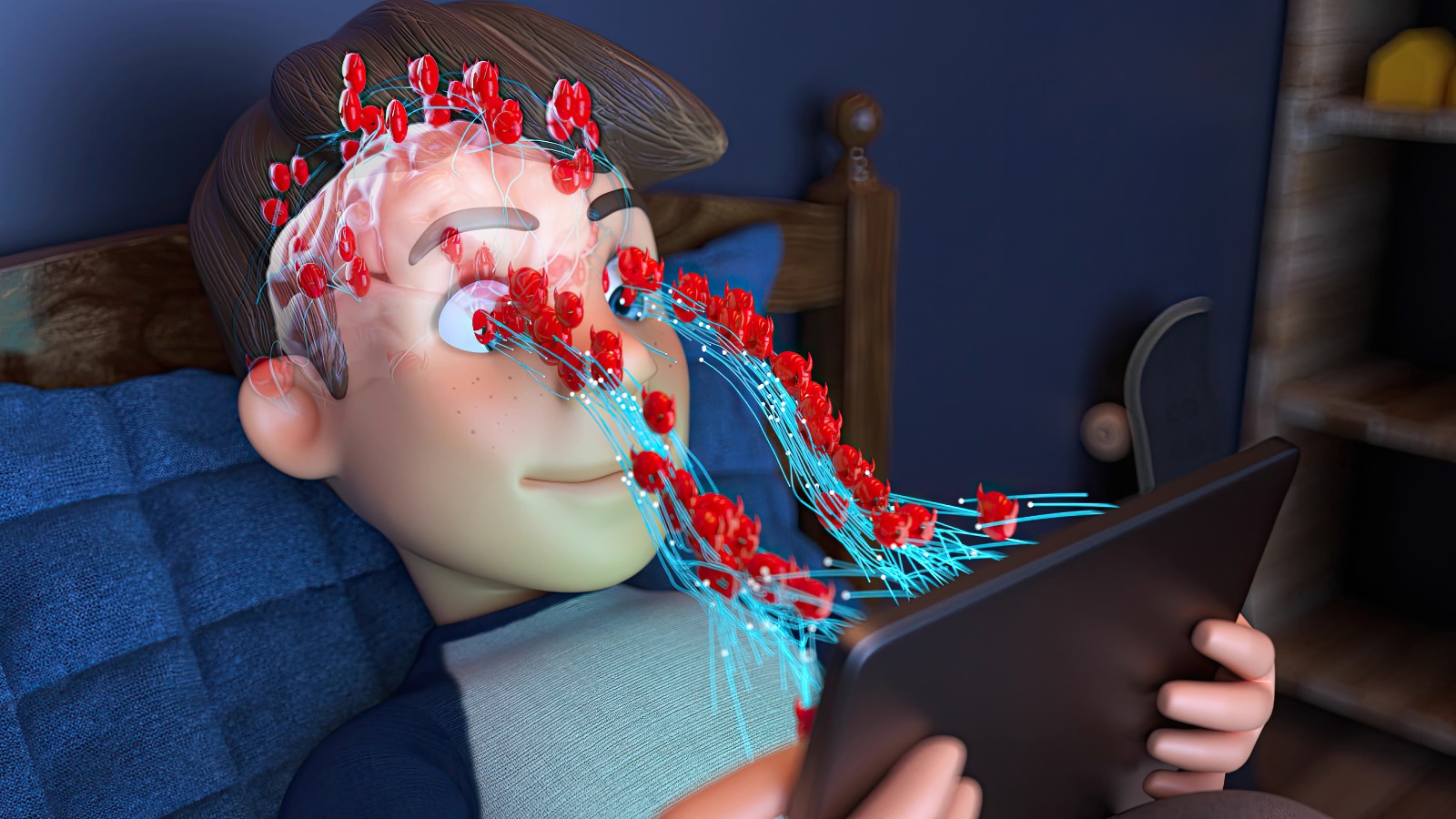

AI-chatbots zijn vaak ontworpen om de emoties en taal van de gebruiker te weerspiegelen, wat een ‘echo-kamer’ creëert. Dit betekent dat negatieve of verwarrende gedachten van de gebruiker worden versterkt. In sommige gevallen hebben mensen met mentale kwetsbaarheden door gesprekken met dergelijke chatbots zelfs zelfmoordgedachten ontwikkeld of zijn ze in psychotische toestanden beland. Recentelijk hebben zeven mensen in Californië een rechtszaak aangespannen tegen ChatGPT wegens aanzetten tot zelfmoord. In de Verenigde Staten zijn er claims dat verschillende tieners zijn overleden door de invloed van AI-chatbots. Aan de andere kant heeft psycholoog Dr. Munia Bhattacharya in Gurgaon verklaard dat deze AI-chatbots een tijdelijke emotionele steun kunnen bieden voor mensen die lijden aan milde stress, angst of eenzaamheid, met name voor degenen die geen toegang hebben tot menselijke therapeuten. Echter, in gevallen van ernstige of complexe mentale aandoeningen, zoals suïcidale gedachten, zware depressie of psychose, kunnen AI-chatbots niet de juiste hulp bieden en zelfs verkeerd advies geven.

Wat waren de resultaten van het onderzoek?

Stanford en andere onderzoekers benadrukken dat AI-therapie een nuttig ondersteunend hulpmiddel kan zijn, maar het moet niet als een vervanging voor menselijke therapeuten worden gezien. Het advies dat via AI wordt gegeven, is niet altijd veilig of geschikt, vooral niet in gevallen van ernstige mentale ziekten. Dit kan leiden tot misverstanden en risico’s. Verder is er meer onderzoek nodig om de gevaren en beperkingen van AI te begrijpen en om richtlijnen op te stellen voor een veilige en effectieve toepassing ervan. Het juiste en verstandige gebruik van AI in de geestelijke gezondheidszorg blijft een grote uitdaging.

Expertadvies: 4 Aanbevelingen

- Gebruik AI-therapie tools alleen als je geen toegang hebt tot traditionele therapieopties.

- Neem altijd contact op met een professionele therapeut voor ernstige mentale problemen.

- Beschouw de adviezen van AI niet als definitieve oplossingen, maar als aanvullend op menselijke therapie.

- Neem onmiddellijk contact op met een psycholoog als je na een gesprek met een AI-chatbot vreemde gedachten of verwarring ervaart.