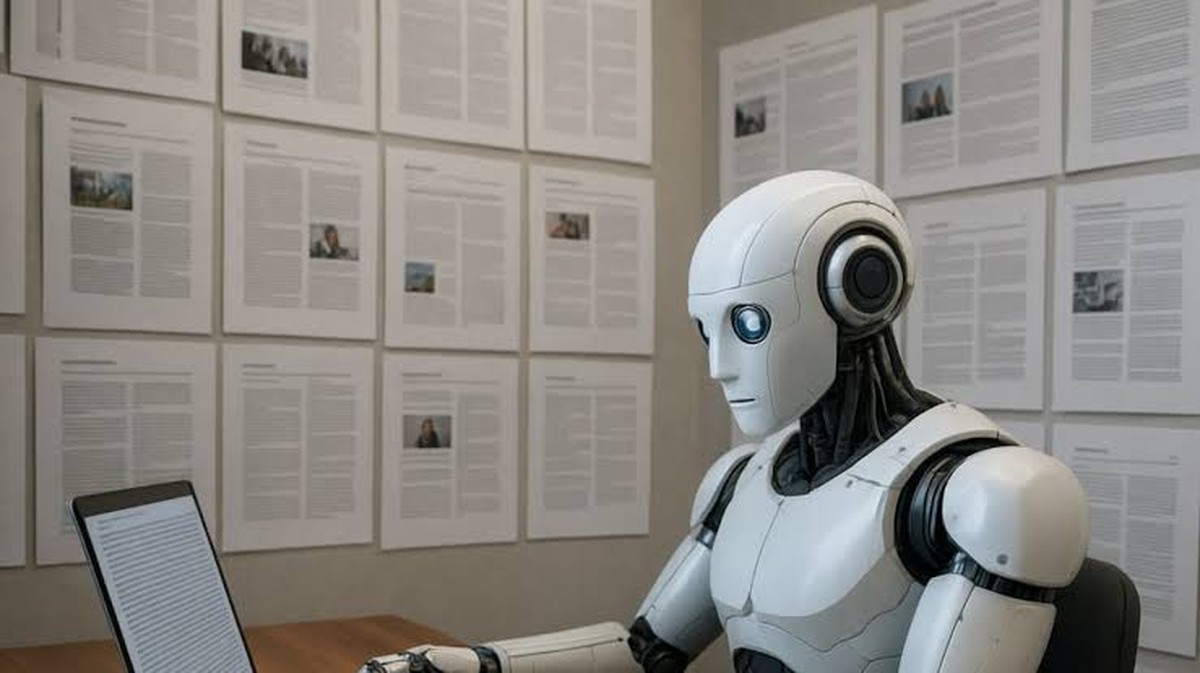

Generatieve kunstmatige intelligentie verlaat de datacenters en komt in onze huiskamers: met een Nvidia RTX-kaart en een paar gerichte инструменты is het mogelijk om lokale taalmodellen en beeldgeneratoren te draaien, waarbij je werkt aan teksten, documenten en grafische projecten zonder de cloud en zonder in te boeten op privacy en gegevenscontrole.

Op een gegeven moment stopten we met vragen hoeveel megapixels de camera van onze telefoon had en gingen we ons afvragen hoeveel bewerkingen per seconde de videokaart van onze pc kan uitvoeren. Dit gebeurde stilletjes, bijna zonder dat we het doorhadden. De oorzaak is de generatieve kunstmatige intelligentie.

Om te begrijpen wat het echt betekent om AI lokaal te maken, hebben we een computer samengesteld die voor iedereen toegankelijk moet zijn, ook al is er een aanzienlijke financiële investering nodig. Het moederbord is een MSI Z890 Carbon Wi-Fi, met een Intel Core Ultra 9 285K, en daaromheen draait een Nvidia RTX 5080 Founders Edition. Dit alles bevindt zich in een Corsair Frame 5000D RS ARGB-kast, gekoeld door een Corsair iCUE Link Titan 360 RX RGB vloeistofkoelsysteem, en aangedreven door een Corsair RM1000E. Het geheugen omvat een Corsair Vengeance RGB DDR5 kit van 64 gigabyte op 5200 MHz, en de werkruimte wordt geleverd door een Corsair MP600 Elite NVMe SSD van 2 terabyte. Veel van deze componenten zijn de laatste tijd in de aanbieding dankzij Black Friday.

Dit is het klassieke pc die een enthousiasteling zou kiezen om op de hoogste details te gamen. Maar tegenwoordig gebeurt er iets anders met dit soort configuraties: dezelfde kracht die een videogame in 4K draait, wordt nu de motor voor het uitvoeren van taalmodellen en beeldgeneratoren direct op je bureau. Niet meer in de datacenters van iemand anders, maar hier, in de kast onder het bureau.

Van Training naar Inferentie: Waar Begint het ‘Lokaal’

Er is een fundamenteel misverstand rondom kunstmatige intelligentie. De fase die maandenlange berekeningen, astronomische energiekosten en hele schuren vol servers vereist, wordt training genoemd. Het is daar waar het model leert door terabytes aan teksten en afbeeldingen te verwerken. Niemand denkt erover om dit in de woonkamer te doen.

Wat we echter thuis kunnen doen, is de andere helft van het verhaal: inferentie. Dit is het moment waarop het model, dat al door iemand anders is getraind, een prompt ontvangt en een antwoord genereert. Een e-mail, een samenvatting, een script, een reeks akkoorden, een illustratie. Het is het moment waarop de AI stopt met leren en begint met werken.

Lokale inferentie betekent dat je dit deel van het werk direct op je pc draait. Het model leeft niet in de cloud, maar op de schijf, en vooral de tekst die we invoeren, verlaat nooit de machine. Wanneer we een LLM vragen om een contract samen te vatten, een stuk code te beoordelen of door onze aantekeningen te navigeren, doet hij dit als gast op onze computer, niet op een externe server.

De Voordelen van Lokale AI

De voordelen zijn bijna banaal en daarom enorm. Geen afhankelijkheid van internetverbindingen, geen oplopende abonneekosten met het aantal verzoeken, en geen onzekerheid over waar de gegevens eindigen. En vooral weinig vertraging: tussen de vraag en het antwoord is er geen internetpakket-tijd, er is alleen de brute kracht van onze videokaart.

LM Studio: De Chatbot op je PC

In dit scenario is LM Studio een beetje het menselijke gezicht van de revolutie. Het is een applicatie voor Windows die één duidelijke functie heeft: het neemt de complexiteit van formaten, runtime en bibliotheken, en verbergt dit achter een chatvenster. De gebruiker krijgt één vraag: “met welk model wil je vandaag praten?”.

LM Studio gebruikt llama.cpp, een open-source bibliotheek in C en C++ die is ontworpen om taalmodellen efficiënt op CPU en GPU uit te voeren. De modellen worden omgezet naar gguf, een formaat dat speciaal voor lokaal gebruik is ontworpen: het neemt minder ruimte in, laadt sneller en ondersteunt kwantisatie, de compressie van precisie waar de tensor cores over spreken.

Het dialog tussen LM Studio en de RTX grafische kaart verloopt via een reeks “runtime’s”, echte uitvoeringsmotoren. Er is er één voor CPU, nuttig voor tests of minder krachtige PC’s, één dat CUDA benut, en één, gebaseerd op de nieuwste versies van CUDA, die zelfs de tensor cores en de optimalisatie van TensorRT volledig benut. Achter de schermen doet hij alles. De gebruiker kiest de runtime, selecteert het model en schrijft de prompt.

Documenten en Context

De echte doorbraak komt echter wanneer we stoppen met het vragen van algemene dingen aan het model en beginnen met het laten lezen van wat we op de pc hebben. Werk-PDFs, tekstbestanden, spreadsheets. In LM Studio volstaat het om op een “+” naast de prompt te klikken om een document aan het gesprek toe te voegen. Vanaf dat moment beschouwt het model die inhoud ook als onderdeel van de context.

Het is de perfecte gelegenheid om de echte betekenis van een “contextuele venster” uit te leggen. Een LLM leest niet eindeloos: het heeft een limiet aan tekst, uitgedrukt in tokens, dat het kan onthouden voor het genereren van een antwoord. De prompt, de geschiedenis van uitgewisselde berichten en alle documenten die we hebben toegevoegd, passen erin. Hoe meer materiaal we toevoegen, hoe minder ruimte er overblijft voor toekomstige dialoog. Wanneer het venster vol raakt, begint het model de oudste delen te “vergeten” om plaats te maken voor de nieuwe.

Conclusie: De Toekomst van Lokale AI

Digitale transformatie in de wereld van AI is aanstaande. Lokale AI met een Nvidia RTX-kaart zal niet het einde zijn van cloud-gebaseerde AI, maar het begin van iets veel persoonlijkers. De computer stopt met een terminal te zijn en wordt weer datgene wat het oorspronkelijk was: een rekenmachine in onze dienst, die geen hulp van buitenaf nodig heeft om zijn werk te voltooien.